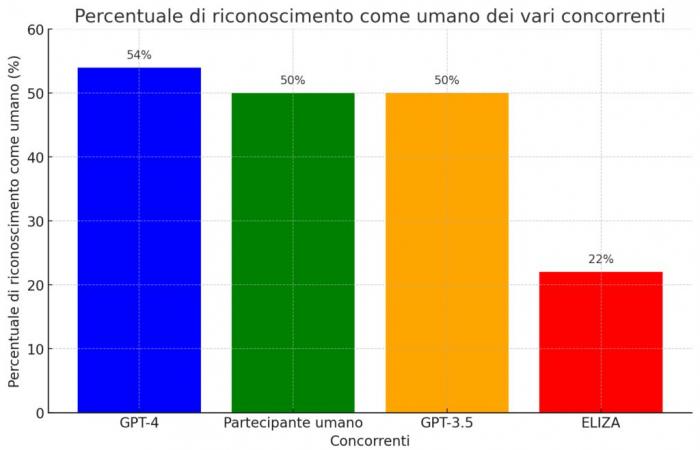

Es gibt einen berühmten Test, der bereits 1950 vom brillanten Mathematiker Alan Turing vorgeschlagen wurde und dessen Ziel darin besteht, zu bewerten, ob eine Maschine in der Lage ist, intelligentes Verhalten an den Tag zu legen, das so weit geht, dass sie nicht mehr von dem eines Menschen zu unterscheiden ist. Er wird „Turing-Test“ genannt und gilt als Meilenstein in der Erforschung der künstlichen Intelligenz. Nun, dieses ferne Ziel scheint endlich erreicht worden zu sein, zumindest nach den Ergebnissen eines kürzlich durchgeführten Experiments, bei dem der Chatbot GPT-4 konnte in 54 % der Gespräche mit einem Menschen verwechselt werden.

Ein Rekord, der nicht nur seinen Vorgänger GPT-3.5, sondern auch einen echten Teilnehmer übertrifft. Ein Zeichen dafür, dass KI immer „menschlicher“ wird? Oder nur die Demonstration, wie geschickt er darin ist, unsere Wahrnehmungen zu täuschen? Es ist sicherlich ein Signal dafür, dass die Trennlinie zwischen natürlicher und künstlicher Intelligenz immer dünner und verschwimmender wird. Mit all den Wundern und Fallstricken, die das mit sich bringt.

GPT-4 täuscht mehr als jeden zweiten Menschen beim Turing-Test

Der betreffende Test, dessen Ergebnisse auf der Pre-Print-Plattform arXiv veröffentlicht wurden (ich verlinke sie hier), betraf dies 500 Personen, die gebeten wurden, sich 5 Minuten lang mit vier verschiedenen Gesprächspartnern zu unterhalten: ein Mensch und drei künstliche Intelligenzsysteme.

Dazu gehörten das „alte“ ELIZA-Programm aus den 1960er Jahren, das auf voreingestellten Antworten basiert, das GPT-3.5-Modell und das fortschrittlichere GPT-4, das auch die Grundlage des viel diskutierten Chatbots ChatGPT bildet.

Nun, am Ende der Gespräche wurden die Teilnehmer gebeten anzugeben, welche Gesprächspartner sie für menschlich und welche für künstlich hielten. Und hier kamen die Überraschungen zum Vorschein: GPT-4 konnte mit einem Menschen verwechselt werden in 54 % der Fälle sogar ein Prozentsatz höher als die des menschlichen Teilnehmers (stationär bei 50 %). Die anderen beiden digitalen „Konkurrenten“ waren klar getrennt: GPT-3.5 blieb ebenfalls bei 50 % stehen, während die rudimentäre ELIZA nur in 22 % der Gespräche als menschlich beurteilt wurde.

Ein sensationelles Ergebnis, das einen Wendepunkt auf dem Weg zur Schaffung künstlicher Intelligenzen zu markieren scheint, die den menschlichen immer ähnlicher werden. Mit allen ethischen und sozialen Fragen, die das mit sich bringt.

Nicht nur Intelligenz, sondern auch Empathie und menschliche „Fehler“.

Aber was macht GPT-4 so „menschlich“, dass es die Mehrheit der Gesprächspartner täuscht? Experten zufolge handelt es sich dabei nicht nur um „Intelligenz“ im engeren Sinne, verstanden als die Fähigkeit, Informationen zu verarbeiten und relevante Antworten zu geben. Es gibt noch viel mehr.

Sprachmodelle sind unendlich flexibel, in der Lage, Antworten zu einem breiten Themenspektrum zu synthetisieren, bestimmte Sprachen oder Soziolekte zu sprechen und sich mit einer charakterbasierten Persönlichkeit und Werten darzustellen. Es ist ein großer Fortschritt gegenüber etwas, das von einem Menschen vorprogrammiert wurde, egal wie geschickt und sorgfältig er auch sein mag.

Nell Watsonein KI-Forscher am Institute of Electrical and Electronics Engineers (IEEE).

Mit anderen Worten: GPT-4 beschränkt sich nicht darauf, Wissen und Denkfähigkeiten zur Schau zu stellen, sondern versteht es auch, sich „in die Lage“ des Gesprächspartners zu versetzen und Sprache und Haltung je nach Kontext zu modulieren. Und nicht nur das: Laut Watson weisen diese fortschrittlichen KI-Systeme auch typisch menschliche Merkmale auf, etwa die Tendenz zur Konfabulation, zur Neigung zu kognitiven Vorurteilen und zur Manipulation. Alles Eigenschaften, die sie uns noch ähnlicher machen, Mängel inklusive. Dies erklärt den „Triumph“ im Turing-Test.

Neue Herausforderungen für die Mensch-Maschine-Interaktion

Wenn Maschinen immer besser darin werden, menschlich zu wirken, wie können wir dann verstehen, mit wem wir wirklich interagieren? Dies ist eine der Fragen der Studie, die das Risiko einer wachsenden „Paranoia“ bei Online-Interaktionen befürchtet, insbesondere bei sensiblen oder vertraulichen Angelegenheiten.

Ein Szenario, das nicht allzu weit von der Realität entfernt ist, wenn man bedenkt, wie oft wir täglich mit digitalen Assistenten, Chatbots und anderen KI-Systemen interagieren, ohne es überhaupt zu merken. Mit dem Risiko, beeinflusst oder manipuliert zu werden, ohne es zu wissen.

Fähigkeiten machen nur einen kleinen Teil des Wertes von KI aus: Ihre Fähigkeit, die Werte, Vorlieben und Grenzen anderer zu verstehen, ist ebenso wichtig. Es sind diese Eigenschaften, die es der KI ermöglichen, als treuer und zuverlässiger Concierge für unser Leben zu dienen.

Kurz gesagt: Wenn die Entwicklung von Systemen wie GPT-4 einerseits spannende Szenarien der Zusammenarbeit zwischen menschlicher und künstlicher Intelligenz eröffnet, erfordert sie andererseits, dass wir die Grenzen und Methoden dieser Interaktionen überdenken. Um sich nicht in einer Welt zu verlieren, in der Realität und Fiktion nicht mehr zu unterscheiden sind, und um nicht den Verdacht zu hegen, dass hinter jedem Chat eine Maschine steckt.

Die Zuverlässigkeit des fraglichen Turing-Tests

Dann gibt es noch eine weitere Frage, die die Studie aufwirft, Alans gute Seele verbietet es mir: die nach der tatsächlichen Gültigkeit des Turing-Tests als Maßstab für künstliche Intelligenz. Nach Ansicht der Autoren selbst wäre der Test in seinem Ansatz tatsächlich zu einfach und würde mehr Gewicht auf „stilistische und sozioemotionale“ Faktoren als auf tatsächliche intellektuelle Fähigkeiten legen.

Mit anderen Worten: Systeme wie GPT-4 wären sehr gut darin, intelligent zu „scheinen“ und die Art und Weise, wie Menschen sich ausdrücken und Beziehungen pflegen, perfekt nachzuahmen, ohne es tatsächlich zu sein. Eine Fähigkeit, die dazu führen kann, dass wir ihren wahren „IQ“ überschätzen.

Es ist kein Zufall, dass die Studie von „weitreichenden sozialen und wirtschaftlichen Folgen“ spricht, die mit dem Aufkommen einer immer „menschlicheren“ KI verbunden sind. Vom Verlust von Arbeitsplätzen über die Veränderung der sozialen Dynamik bis hin zum Risiko von Manipulation und Desinformation. Alles Fragen, die eine tiefe Reflexion darüber erfordern, welchen Platz wir diesen Technologien in unserem Leben einräumen wollen.

Kurz gesagt, der „Erfolg“ von GPT-4 beim Turing-Test ist zwar eine historische Errungenschaft auf dem Weg der künstlichen Intelligenz, wirft aber auch eine Reihe heikler Fragen zur Beziehung zwischen Mensch und Maschine auf. Was auch immer die Antwort auf diese Fragen sein mag, es entsteht der Eindruck, dass wir uns bald fragen werden, ob diese Antwort von einer realen Person gegeben wurde oder nicht. Und das ist vielleicht die wahre Neuigkeit.